Предмет: Алгебра,

автор: dktaelw

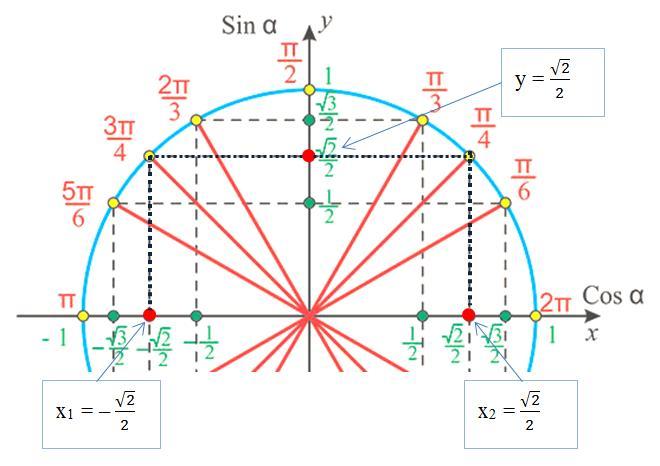

Точка M расположенная на единичной полуокружности имеет координату y=√2/2. Какова может быть координата x этой точки?

Приложения:

ГАЗ52:

√2/2 или -√2/2

Ответы

Автор ответа:

1

Ответ:

Координаты х могут быть или

Объяснение:

На единичной полуокружности каждой точке с ординатами y₀ соответствуют 2 точки с абсциссой х (см. рисунок).

Точке соответствуют 2 точки (соответствия указаны):

или

.

#SPJ1

Приложения:

Похожие вопросы

Предмет: Английский язык,

автор: mhf5465464

Предмет: Українська мова,

автор: rgdrfgsrf2

Предмет: Английский язык,

автор: sobiroovjaloliddin

Предмет: Математика,

автор: Nastya2005sens

Предмет: Қазақ тiлi,

автор: tulebaevamir391